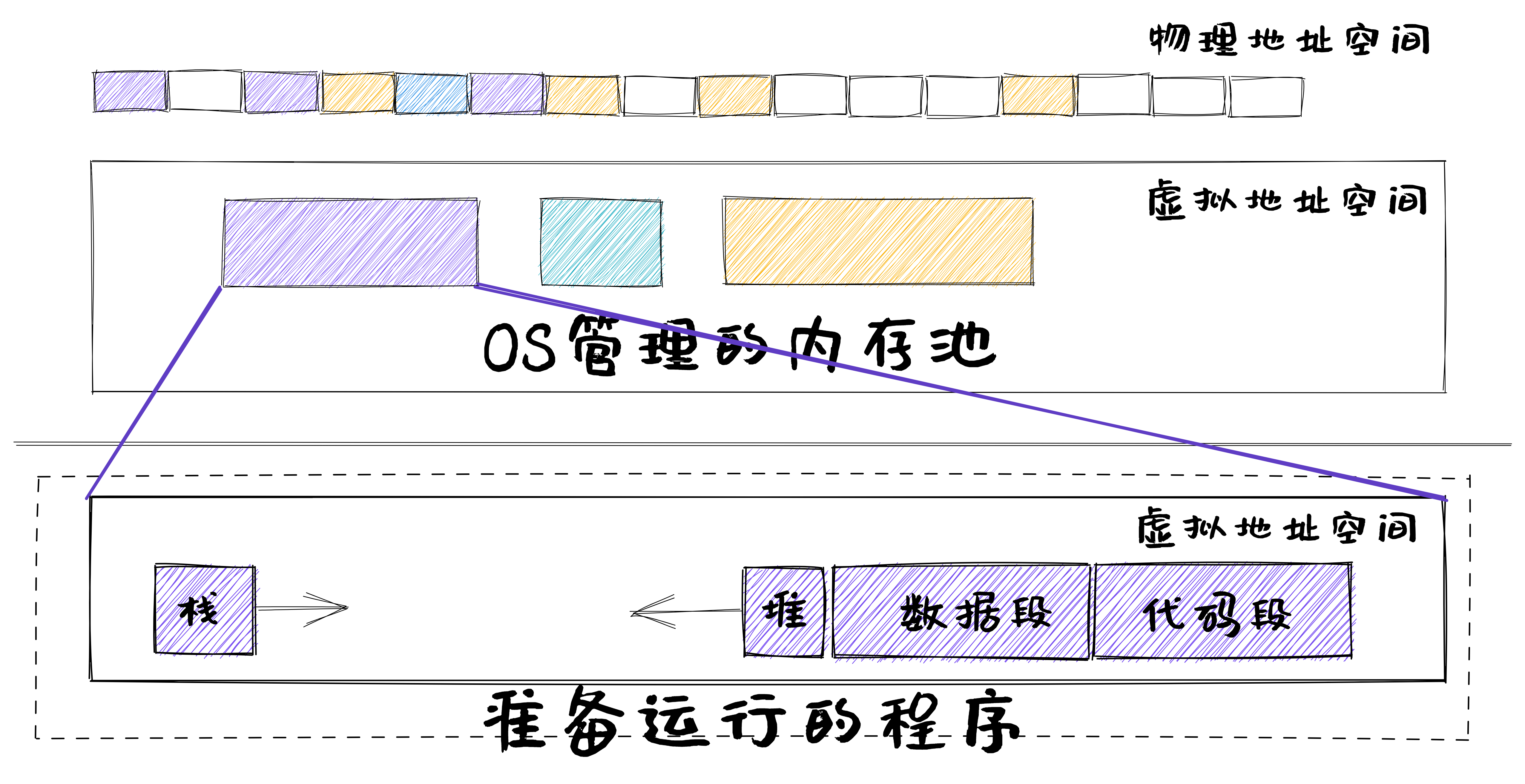

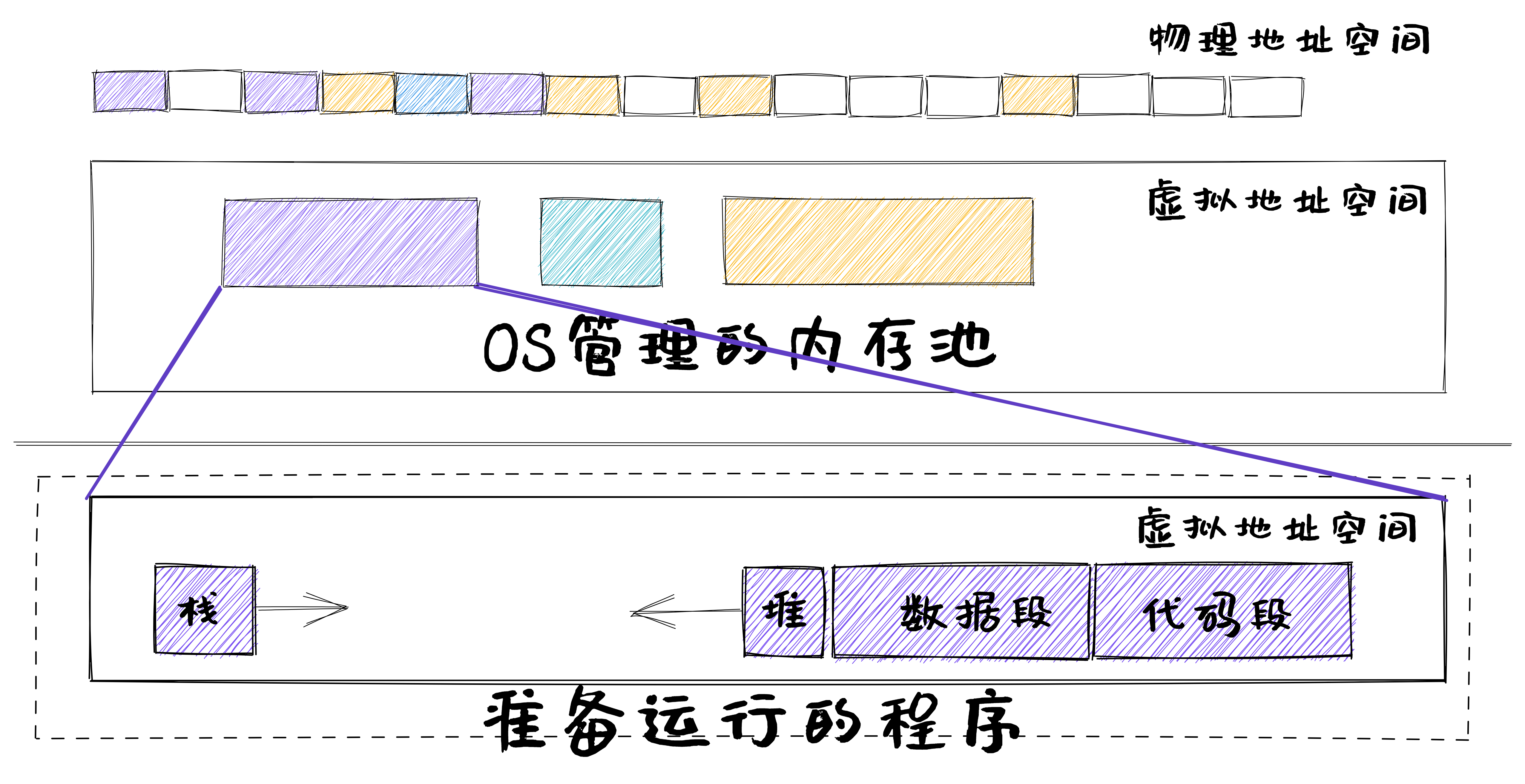

app的地址空间

加载程序运行

第一步:OS加载程序运行

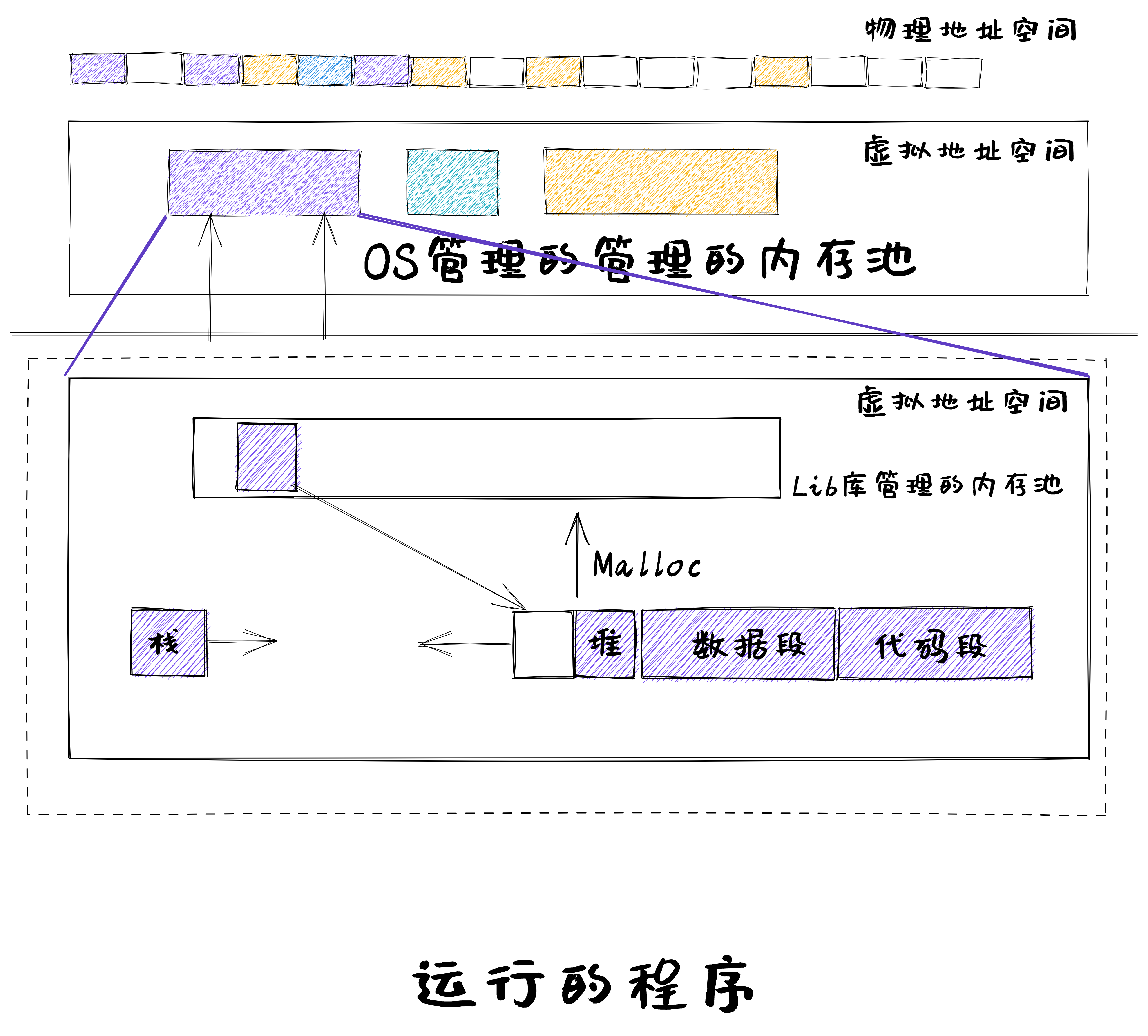

malloc函数调用

第二步:程序发出malloc函数调用,且Lib库有空闲空间

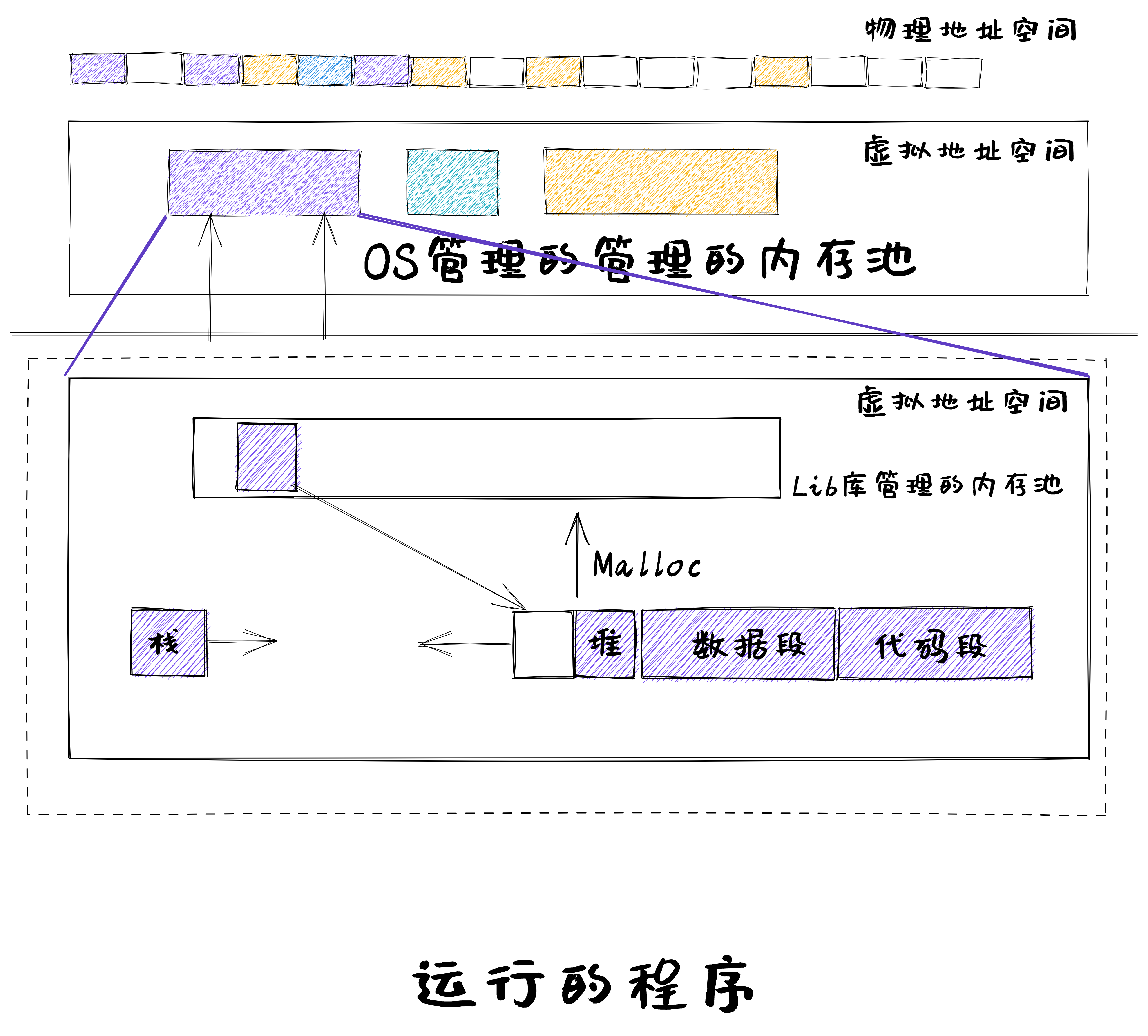

内核分配内存空间

第二步:程序发出malloc函数调用,且Lib库无空闲空间

小结

- 连续内存分配

- 静态分配、动态分配(最先、最佳、最差)

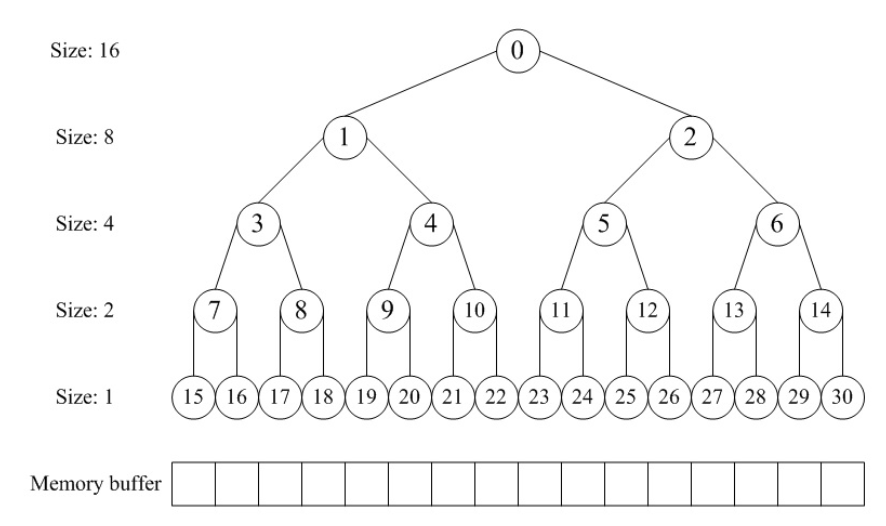

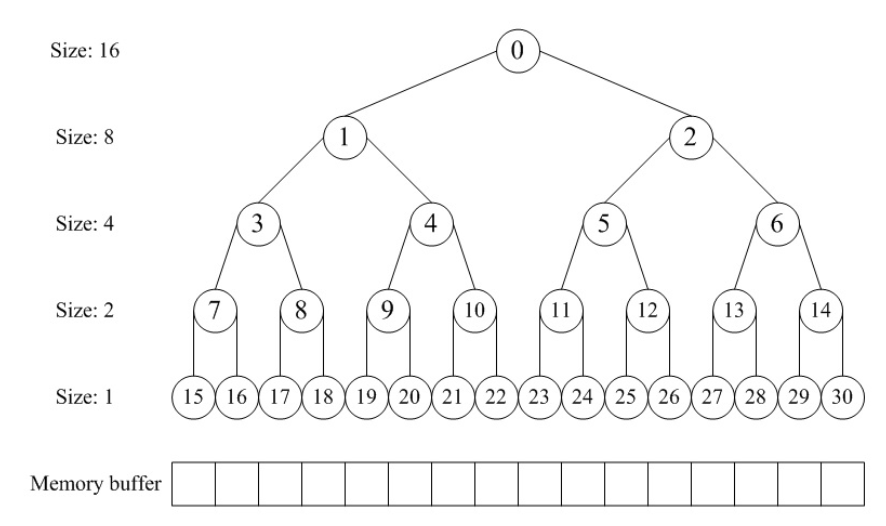

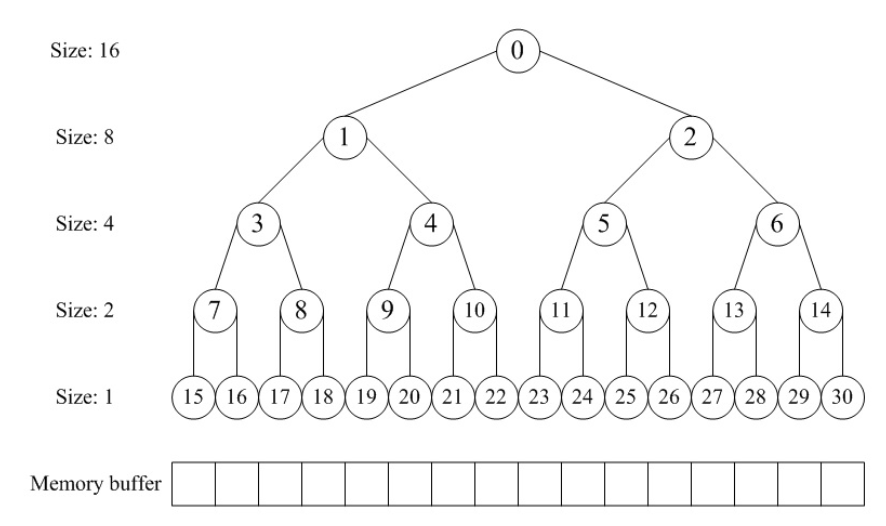

- 分配算法实例:伙伴系统

- 非连续内存分配

- 段式、页式、段页式

- 页表:多级页表、反置页表

第一步:OS加载程序运行

第二步:程序发出malloc函数调用,且Lib库有空闲空间

第二步:程序发出malloc函数调用,且Lib库无空闲空间

http://en.wikipedia.org/wiki/Buddy_memory_allocation

- 64位计算机系统中,如果每页1024字节,那么一个页表的大小会是多少?

2017ppt